En janvier 2021, il a tourné avec le célèbre youtubeur Aypierre une vidéo de vulgarisation scientifique sur le tatouage numérique des images dans le cadre du projet CPER Numeric ¹.

Cette vidéo a rencontré un énorme succès ! Que tirez-vous de cette expérience ?

C’était très intéressant ! Aypierre est une célébrité auprès des jeunes (il compte 1,47 million d’abonnés sur sa chaîne YouTube). Cette vidéo de vulgarisation est assez différente de sa production habituelle sur les jeux vidéo, mais elle a été vue plus de 70 000 fois, ce qui est un excellent score !

Le tournage, qui a duré plus de 3 h, a été agréable et le résultat, une vidéo de 20 minutes, témoigne d’un montage dynamique et d’une grande pédagogie. Les commentaires témoignent d’un vrai intérêt des spectateurs et spectatrices pour un sujet plutôt technique.

On vous entend parler de tatouage numérique, de cryptologie ou cryptographie, de stéganographie, de stéganalyse, d’intelligence artificielle : pour le grand public, cela reste assez mystérieux. Pouvez-vous nous rappeler ce dont il s’agit ?

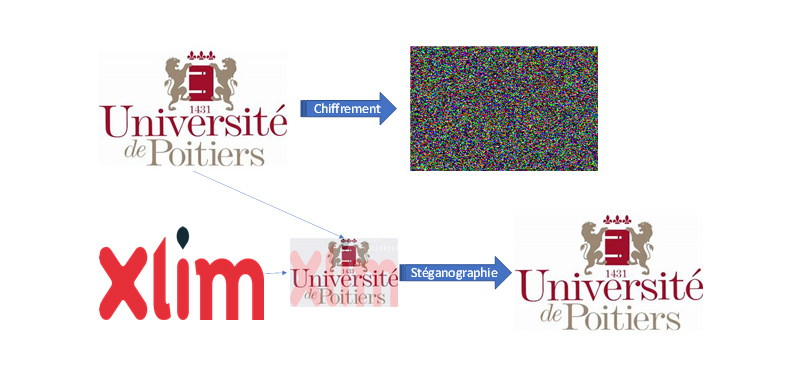

En ce qui concerne la stéganographie ou la cryptologie, il s’agit en fait de pratiques très anciennes, consistant transmettre en toute sécurité un message mais en suivant deux stratégies différentes. Étymologiquement, la cryptologie est la parole/discours raisonnable (logos) du secret (kruptos) : elle consiste à rendre un message illisible pour qui ne possède pas la clef de déchiffrement. La cryptographie s’appuie par exemple sur des principes issus de la théorie des nombres donc des mathématiques fondamentales — d’où le nom de « chiffrement ». L’information est « chiffrée » avec une clef (ou encryptée, les deux mots s’utilisent même si les puristes n’aiment pas l’anglicisme) en une suite de nombres rendant illisible le message initial. Même si tout le monde connaît l’algorithme, la lecture de l’information est impossible sans la clef.

Le temps de calcul nécessaire au « dé-chiffrement » d’un message ainsi émis est si long que la méthode rend le message inviolable. Néanmoins, la perspective de l’utilisation d’ordinateurs quantiques, beaucoup plus rapides, fait que la recherche sur le chiffrement ou cryptage est toujours d’actualité — même s’il s’agit d’une perspective encore lointaine.

Par ailleurs, la stéganographie, du grec steganos (dissimulé) et graphè (écriture) consiste à faire passer un message dans un autre message. On en trouve trace dès Hérodote (Ve siècle av. J.-C.) à propos de messages secrets envoyés pendant la seconde guerre médique. On cite aussi souvent l’art moins guerrier de l’acrostiche, parfois coquin, comme ceux que l’on attribue à George Sand et Musset.

Dans la vidéo avec Aypierre, nous avons évoqué la technique de stéganographie qui consiste à dissimuler une marque (un dessin, un logo, peu importe) dans une autre image sans que cela soit visible à l’œil nu, ce qu’on appelle le « tatouage numérique » (watermarking) : enfouir un message secondaire, porteur d’information, dans un message primaire anodin. Cela a d’ailleurs été exploité souvent au cinéma ! On pense par exemple au film de C. Pinoteau Le Silencieux (1973) : en pleine guerre froide, un chef d’orchestre soviétique fait passer des informations cachées dans une partition grâce à une note de musique qui contient tout un texte.

Le contexte du numérique change les méthodes, mais le principe est le même ! Dans la vidéo, nous montrons comment marquer une image sans qu’il y paraisse en substituant des éléments (des bits) des pixels de cette image par d’autres. La modification est invisible à l’œil nu et rend l’image parfaitement identifiable. L’objectif de la vidéo, tout en expliquant le principe général de la stéganographie, est de permettre aux jeunes visionnant cette capsule de réaliser eux-mêmes leur algorithme de stéganographie.

Au-delà de l’espionnage, la problématique est également celle de la sécurité de la donnée en ce qui concerne sa certification (propriété intellectuelle ou détection de modification de contenu par exemple). Au laboratoire XLIM, nous travaillons ainsi avec une entreprise qui offre à ses clients une solution de « tatouage » de leur base de données d’images : le but est d’abord de marquer ces contenus multimédias comme appartenant à l’entreprise, mais aussi, si cette dernière trouve, par exemple sur Internet, une image lui appartenant, d’être capable de dire comment elle est sortie de la base, où se situe la faille de sécurité.

La thématique n’est donc pas liée à la seule informatique ?

Non, car l’axe de recherche est très large. C’est un sujet éminemment transversal où interviennent autant des spécialistes de l’informatique, des mathématiciens, que des juristes ou des spécialistes du traitement de l’image et de la perception visuelle ou de l’intelligence artificielle.

La compréhension du capteur humain peut avoir une certaine importance dans ce type de travaux. Nous évoquions avec Aypierre le fait de « tatouer » une image de manière imperceptible, mais assez robuste pour résister à des modifications avec des logiciels multimédias ou de compression. On s’est ainsi aperçu qu’il était plus efficace de dissimuler des informations dans la couleur bleue, car c’est la couleur pour laquelle le système visuel humain est a priori le moins sensible aux modifications.

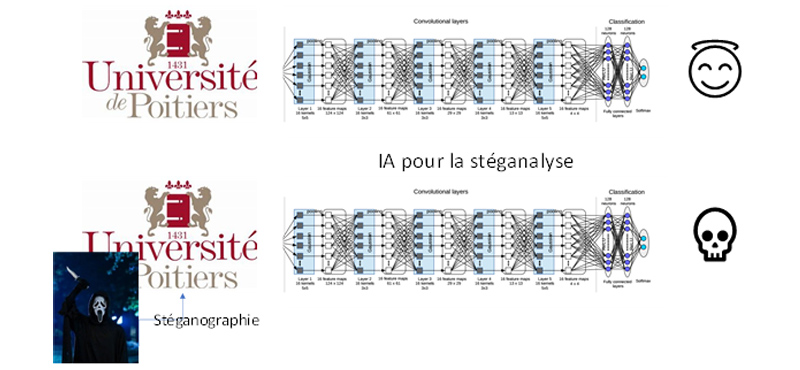

Enfin, au laboratoire XLIM nous menons aussi des recherches qui consistent à se placer dans la position inverse, à savoir détecter des images « truquées ». Y a-t-il ou pas une modification de l’image, potentiellement une image cachée dans une autre image, et si oui, comment l’extraire ? C’est ce qu’on appelle la stéganalyse. Pour cela, nous faisons appel notamment à l’intelligence artificielle pour essayer de détecter ces modifications, ces perturbations dans les images et éventuellement de prendre une décision (les laisser circuler ou pas, par exemple). La difficulté est qu’une IA se paramètre à travers un apprentissage, un entraînement par l’exemple. Le problème sera dès lors qu’une IA ne pourra reconnaître que ce qu’elle a déjà rencontré : il faut alors lui apprendre à extrapoler et à être capable de reconnaître des techniques de transformation qui n’auraient encore jamais été utilisées. Nous sommes alors face à l’un des défis de l’IA : la capacité de généralisation des systèmes de décision automatique.

[1] (financé par l’État, la région Nouvelle-Aquitaine, l’Union européenne, Grand Poitiers, Grand Angoulême, Agglo La Rochelle, département de Charente-Maritime), à l’initiative de François Lecellier, maître de conférences également membre de XLIM